2025年,AI智能体成为企业级工具,智能体架构决定其效率与演化方向。文章深度解析构建AI智能体的9大核心技术,包括从执行工具到自主决策、多智能体协作、工作流设计、检索增强生成、微调、函数调用、模型通信协议、智能体间通信及前端交互标准,这些技术共同构成可用、可落地、可拓展的AI智能体系统。

2025年,AI智能体已经不再是概念模型,它们正在逐步落地为企业级工具、产品模块,甚至成为工作流的“第二大脑”。

而在这背后,一整套系统化的智能体架构,正悄然决定着这些Agent的效率、扩展性与演化方向。如果说大语言模型(LLM)是AI的发动机,那么“智能体架构”就是决定AI能走多远的底盘和驾驶系统。

本文,我们将深度解析构建AI智能体所需掌握的9大核心技术——从底层调度逻辑到协议层标准,从人机交互到多智能体协同,全面还原一个真正可用、可落地、可拓展的AI Agent系统构建地图。

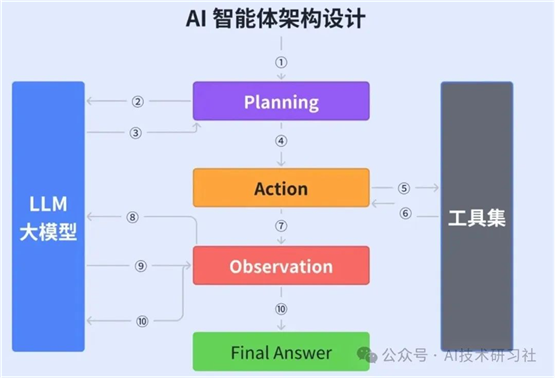

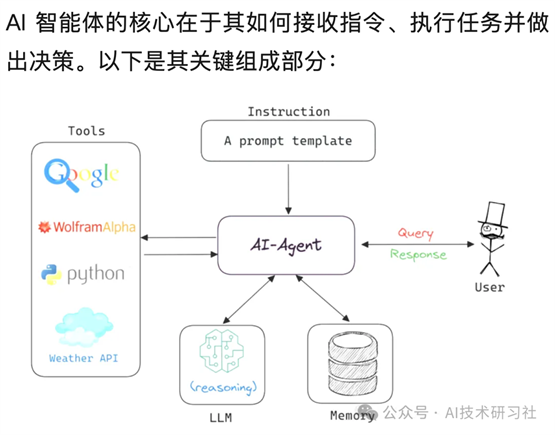

一、AI智能体:从执行工具到自主决策者

AI智能体的本质是一种具备自主意识的软件,它能够感知环境、进行逻辑推理和决策,并实施相应动作。

通过Prompt定义其指令语义,以Switch语句解析下一步行为,以累积上下文维持对任务的持续理解,再由For循环驱动整个执行逻辑。

它不再是“你说我做”的Chatbot,而是一个能感知任务环境、做出规划,并根据反馈动态调整的数字合作者。

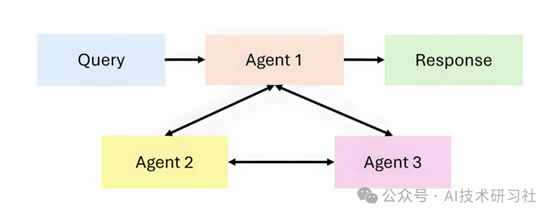

二、Agentic AI:一人合奏到交响协同的跃迁

单体智能体只能执行有限任务,而Agentic AI构建的是一个AI多智能体协作体系。每个智能体承担特定角色,彼此通过共享记忆、任务编排、状态反馈组成任务协同网络。

在Agentic AI 系统中,每个 AI 智能体都有其独特的角色和能力,它们可以相互协作、共享信息,并根据任务需求动态调整策略。这种协作模式让系统能够应对那些超出单个 AI 智能体能力范围的复杂任务。

它不仅让智能体处理更复杂的业务逻辑,还首次具备了“智能体的组织能力”。医疗、科研、金融等领域对这种架构需求正在迅速上升。

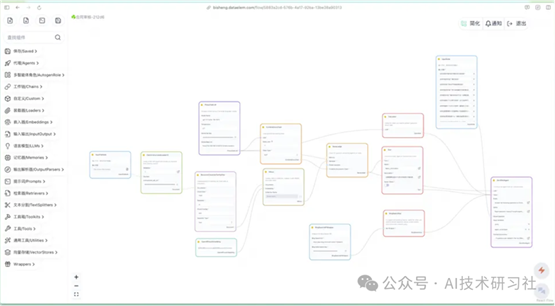

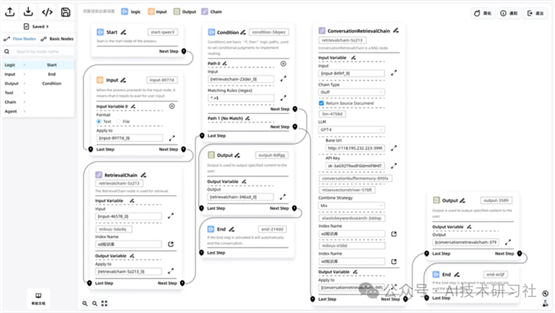

三、WorkFlow:给智能体装上一条清晰可控的生产线

工作流就是把复杂任务“拆、编、排”。相比让LLM即兴发挥,工作流设计把业务拆分为标准化步骤,让智能体在清晰路径中逐步执行,避免出现幻觉或不合理跳转。

AI制单、客服处理、内容审校等场景对工作流依赖极强,搭建一个可调、可追踪的流程,是系统工程的起点。

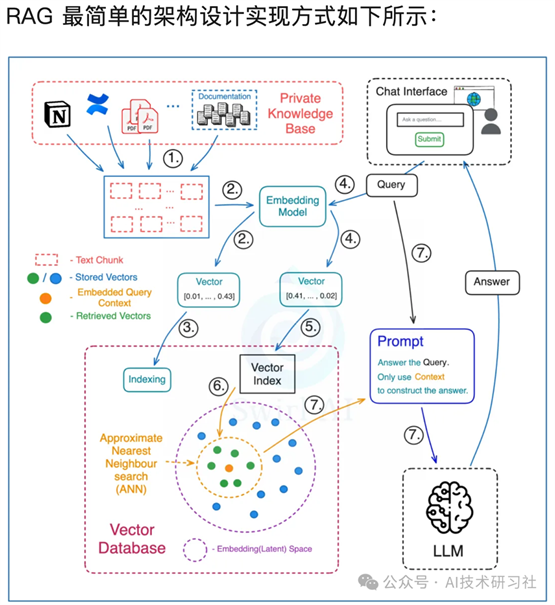

四、RAG:让AI真正学会“看资料答题”

RAG(检索增强生成)为智能体插上了“实时学习”的翅膀。它的关键在于:将文档转为向量,存入数据库,再用语义查询匹配用户提问与文档段落,反馈上下文给大模型作答。

这种方式不仅让模型“记住”你给它的知识,还能控制它“不乱说话”。企业文档问答、知识库助手、垂直客服都是RAG的高频应用场景。

五、Fine-tuning:从“聪明通用”到“专精领域”的关键一步

通用大模型强,但不懂你企业的术语和业务逻辑。Fine-tuning(微调)让通用模型变成“行业专家”。

通过成对数据(Q-A)训练,让模型掌握特定表达风格与逻辑习惯。全量微调适合定制大模型,PEFT等轻量方式适合场景微调。想要智能体贴地飞行,Fine-tuning 是不可绕过的一步。

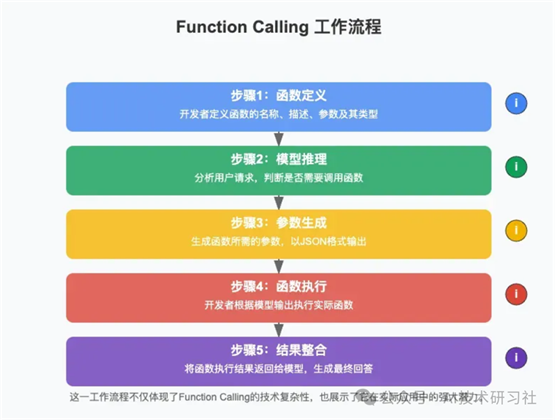

六、Function Calling:让语言模型动起手来

Function Calling打通了大模型到工具系统的最后一公里。Function Calling 的工作原理可以通过以下5个步骤来理解:

1、识别需求:大模型识别出用户的问题需要调用外部 API 来获取实时信息。比如:用户询问“今天北京的天气如何?”大模型会识别出这是一个关于实时天气的问题。2、选择函数:大模型从可用的函数库中选择合适的函数。在这个例子中,大模型会选择

get_current_weather 函数。3、准备参数:大模型准备调用函数所需的参数。例如:

{ "location": "北京", "unit": "celsius"}

4、调用函数:AI 应用使用这些参数调用实际的天气 API,获取北京的实时天气数据。5、整合回答:大模型将获取的数据整合成一个完整的回答,比如:“根据最新数据,北京今天的天气晴朗,当前温度23°C,湿度45%,微风。今天的最高温度预计为26°C,最低温度为18°C。”

大模型识别用户需求、调用接口函数,执行任务,如查天气、写SQL、发邮件等。它让语言模型具备“动手能力”,不仅能说,还能做。

对于开发者,Function Calling 是一种强大的工具,它为大语言模型提供了与外部工具和服务交互的能力,从而解决了大模型知识更新停滞的问题。然而,它的局限性在于缺乏跨模型的一致性和平台依赖性。

尽管如此,Function Calling 仍然是一个重要的技术,尤其是在需要快速实现特定功能时。未来,随着技术的不断发展,我们期待看到更多能够克服这些局限性的解决方案。

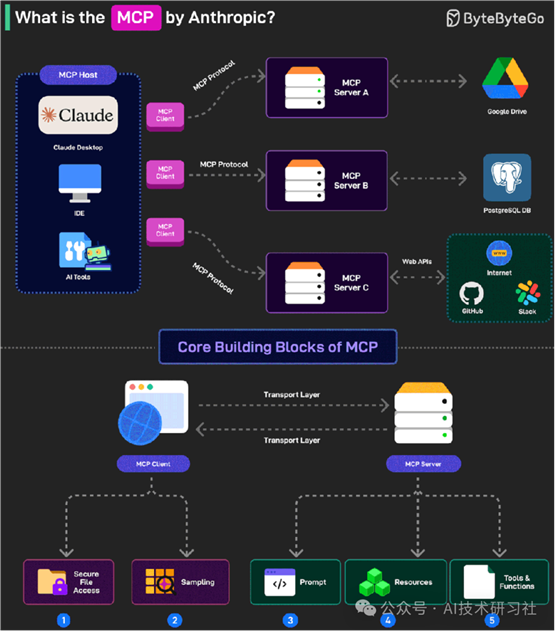

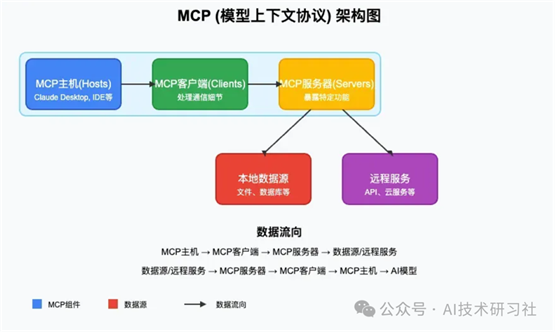

七、MCP(Model Context Protocol):打破模型孤岛的统一接口

MCP由Anthropic提出,统一了不同模型与外部工具、数据源之间的通信标准。

通过Host-Client-Server架构,MCP可以安全地访问本地或远程资源。

Claude、GPT、通义千问、DeepSeek、Cursor等主流模型均已加入MCP生态,它正成为“模型接入互联网”的标准协议。

对开发者而言,MCP是搭建具备实用能力Agent的标配工具。

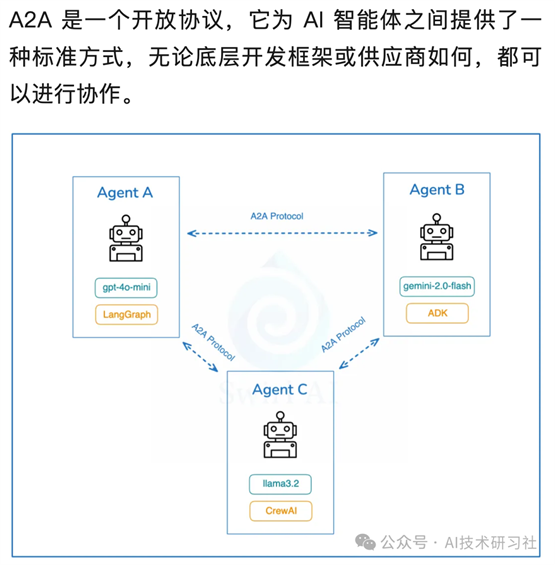

八、A2A(Agent2Agent):让智能体学会彼此配合

在多Agent系统中,不同智能体可能基于不同框架开发(如LangGraph、CrewAI、AutoGen等),彼此之间无法互通任务和状态。

A2A提供统一通信协议,使智能体可以交换任务、共享状态、进行异步协作。

AgentCard机制定义了能力发现方式,标准协议基于JSON-RPC、SSE等工业标准,可嵌入企业现有IT系统,安全性和可扩展性并存。

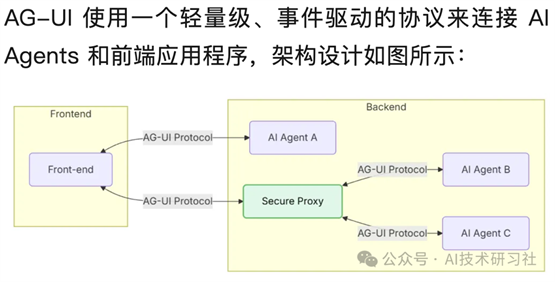

九、AG-UI:为前端交互装上AI的“标准神经”

AI Agent 不只是后台大脑,还需要一个好用的前端接口。

AG-UI

就是这个标准协议。它通过SSE/WebSocket实现前后端双向通信,并内置了16种交互事件,支持多Agent管理、安全代理等机制。

避免每次都从零开发UI组件,是构建AI对话助手、客服系统的高效方案。AG-UI 让AI智能体在网页、APP、嵌入式设备中“自然生长”。

总的来说,AI智能体架构的设计,不再是工程细节的堆叠,而是一场关于效率、连接和演化的系统性革命。这9大核心技术,既是智能体构建的底层基座,也是未来AI系统能否走向真实世界的关键通道。

面对下一波AI浪潮,理解智能体架构不只是技术选型,更是参与未来的门票。如果你是开发者、产品经理,甚至是企业决策者,现在正是你掌握智能体核心架构的最佳时机。

原文出自:https://mp.weixin.qq.com/s/SW8-iyjm1e2mUcnX7h_UXw

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip