Qwen3,一款强大的开源AI模型,在假期前夕发布,具备卓越编码、数学及通用能力,支持多语言、多种思考模式和模型尺寸,可本地运行,通过Ollama和Chatwise软件在Windows等系统下快速部署和运行。

在假期来临前夕,千问犹如一颗璀璨的流星,为科技界带来了一个震撼的惊喜——Qwen3!这一开源模型的诞生,无疑是给人工智能领域投下了一枚重磅炸弹,瞬间引发了广泛的关注和热议。

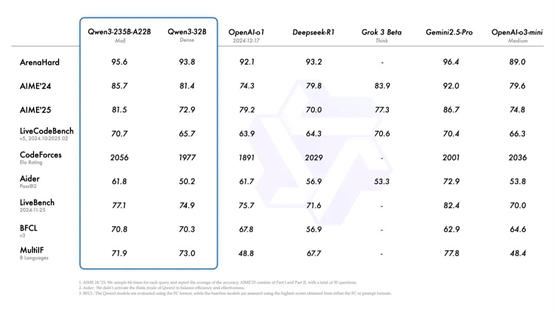

Qwen3在编码、数学、通用能力等多个关键领域展现出了卓越的实力,完全有能力与Gemini、ChatGPT、Grok等顶尖模型一较高下。下面让我们通过一组数据来直观感受一下它的强大:

Qwen3不仅能力出众,而且具有极高的可玩性。它支持开关深度思考能力,就像给模型配备了一个智能大脑的开关,你可以根据实际需求灵活调整。同时,它提供了多种尺寸的模型,可以在不同设备上轻松运行,无论是性能强大的电脑,还是普通的移动设备,都能找到适合自己的模型版本。此外,它还支持119种语言,真正实现了全球语言的无障碍交流,并且特别增强了智能体能力,支持MCP,为用户带来更加智能、便捷的使用体验。

更值得一提的是,Qwen3全部开源,提供了从0.6B到235B的全尺寸模型。这对于想要在本地运行模型、进行私有化部署的用户来说,无疑是一个绝佳的选择。最小的模型只有523M,而40亿参数的模型也仅仅只有5.2G,一张8G的显卡就可以轻松运行,但其能力却可以匹敌Qwen2.5 - 72B,简直就是小身材大能量!看到这里,你是不是已经迫不及待地想要在本地跑一跑这个强大的模型了呢?

关于Qwen3更多的特点,你可以阅读这篇文章《假期狂欢Qwen3来了,强到离谱!多种思考模式,多种模型尺寸,119种语言,MCP支持,开源,可本地运行!》。接下来,我将详细演示如何在Windows系统下,通过Ollama和Chatwise等软件,快速部署和运行Qwen3。这种方式非常简单,完全不需要你懂代码,也不需要进行任何复杂的配置,甚至不需要魔法上网,只要跟着我的步骤来,你就能轻松拥有属于自己的本地AI对话模型。

安装Ollama

Ollama是一款非常适合体验新模型的工具,它就像一个神奇的魔法盒,只需一行命令,就可以轻松加载和运行模型。目前,Ollama已经全面支持Qwen3全系列模型了。

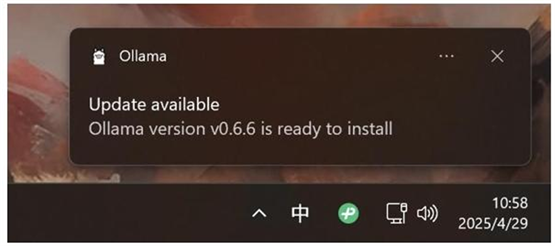

所以,第一步我们要做的就是安装或者更新Ollama到V0.6.6版本。如果你之前已经安装过了,那么操作就非常简单了。你只需要点击系统托盘,找到Ollama的图标,然后右键点击,在弹出的菜单中点选“重启更新”即可。

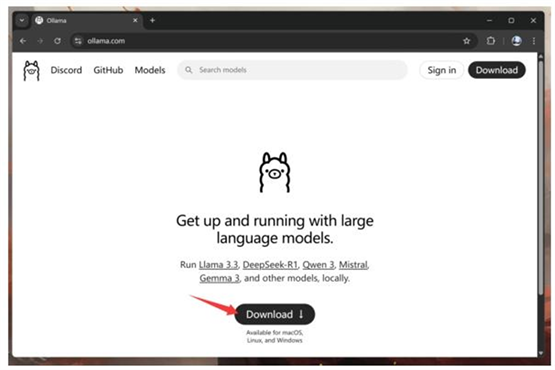

如果你之前没有使用过Ollama,也不用担心,我们可以去ollama.com这个网站下载软件。

在网站上,你只需要点击“Download”按钮,就可以下载Windows版本的Ollama了。当然,如果你使用的是macOS或者Linux系统,也不用担心,Ollama同样支持这些系统,你只需要下载对应版本的软件即可。下载完成之后,双击安装程序,就像安装普通软件一样,按照提示一步一步操作,安装完成之后,软件会自动启动,你会在右下角的托盘中看到Ollama的图标。

下载模型

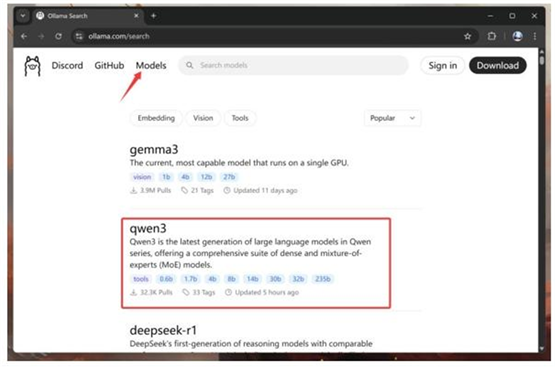

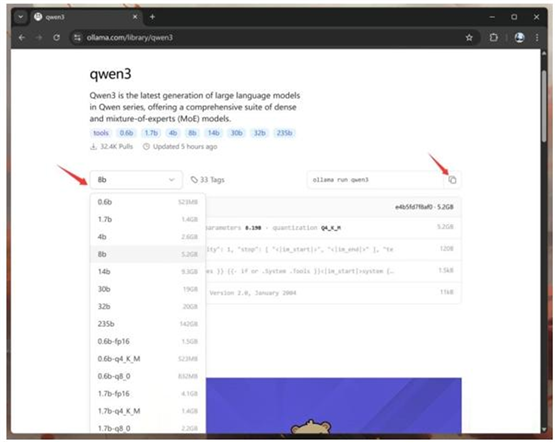

当Ollama软件安装完成之后,我们就可以开始下载Qwen3模型了。首先,打开网页,点击“模型(Models)”选项,然后找到Qwen3。

你会发现,Qwen3已经在热门排行榜上位居第二名了,从卡片信息中可以看到,它发布仅仅五个小时,就已经有32k的下载量了,这足以证明它的受欢迎程度。点击Qwen3,进入详情页。

在详情页中,复制命令“ollama run qwen3”。接下来,我们要打开CMD命令提示符。

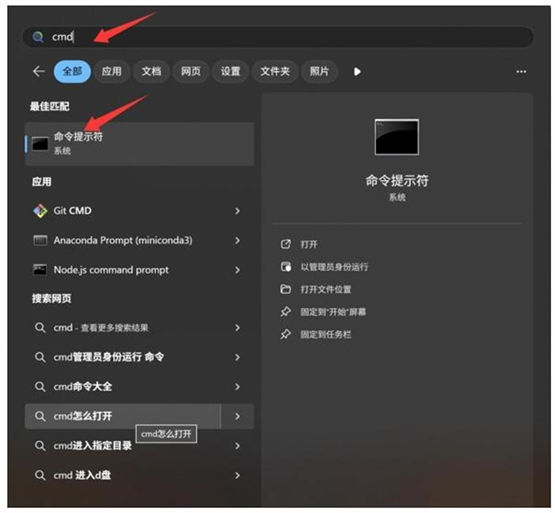

你可以直接在系统搜索框中输入“cmd”,然后回车打开即可。这是系统自带的命令工具,就像一个神奇的控制台,我们可以通过它来执行各种命令。在CMD中,输入或者粘贴命令“ollama pull qwen3”,然后按一下回车键(Enter)。

命令提示符 - ollama

pull qwen3

Microsoft Windows[版本10.0.26100.3915] (c)Microsoft Corporation,保留所有权利。

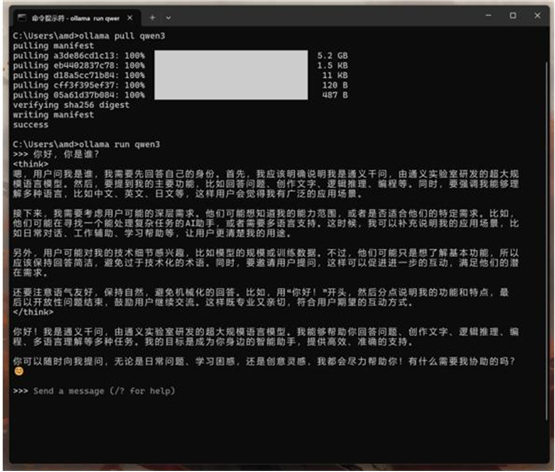

C:\Users\and>ollama pull qwen3 pulling manifest

pulLing a3de86cd1c13: 1%| 70MB/5.2GB 7.3MB/s 11m45s

这时,Ollama就会开始下载模型了。需要注意的是,如果使用“pull”命令,只是下载模型,不会运行;如果使用“run”命令,下载之后会自动载入模型。为了让步骤更加清晰,我这里先使用“pull”命令下载模型,下载完成之后再运行。

运行和对话

当模型下载完成之后,我们就可以运行模型,开始和它进行对话了。在CMD中输入命令“ollama run qwen3”。

输入命令之后,你就可以直接输入问题了。比如,我这里先礼貌地问一句“你好,你是谁”,千问就会直接回答你。从回答过程中可以看到,即便是8B的模型,默认也是具备深度思考能力的(在“think”标签里面可以体现)。

然后,我们可以问一下它的核心技能:

>>>你有什么特别的技能?

<think> 用户问我的特别技能,我需要详细列举我的能力。首先,我应该提到我的多语言支持,比如中文、英文、日文等

域,这样用户会觉得我有全面的信息储备。 这样用户知道我可以处理不同语言的需求。然后,要强调我的知识范围广泛,涵盖科学、文化、技术等多个领

接下来,我需要说明我的应用场景,比如日常对话、工作辅助、学习帮助等,这样用户能更清楚我的用途。同时 的点,可以展示我的灵活性和适应性。 要提到我的逻辑推理和编程能力,因为这些是用户可能需要的实用技能。此外,创造力和个性化服务也是重要

还要注意语气友好,保持自然,避免技术术语过多,最后,邀请用户提问,促进进一步的互动。这样既专业又亲 切,符合用户期望的互动方式。

</think>

我有以下一些特别的技能,可以帮你解决各种问题:

**多语言支持**

我能流畅地使用中文、英文、日文、韩文、法文、西班牙文等语言进行交流,适合跨语言沟通和内容创作。

**知识覆盖广泛**

我掌握科学、文化、技术、历史、艺术等领域的知识,可以回答从基础常识到专业问题的各类问题。

**逻辑推理与分析**

我能帮助你进行逻辑推理、数学计算、数据分析,甚至解决复杂的编程问题。

**创意与写作**

我可以协助创作故事、诗歌、剧本,或者帮你润色文案、设计对话,让文字更生动有趣。

**个性化服务**

根据你的需求,我可以调整回答风格(比如更正式、更口语化),或者提供针对性的建议。

**学习与辅助**

我能帮助你理解复杂概念、整理学习资料,甚至模拟考试或练习题解答。

**跨领域协作**

无论是日常对话、工作规划,还是创意项目,我都能提供灵活的支持。

如果你有具体的需求,可以告诉我,我会尽力帮你!

>>> Send a message (/? for help)

它自己总结了一下7个特点:

1. 多语言支持:我能流畅地使用中文、英文、日文、韩文、法文、西班牙文等语言进行交流,适合跨语言沟通和内容创作。

2. 知识覆盖广泛:我掌握科学、文化、技术、历史、艺术等领域的知识,可以回答从基础常识到专业问题的各类问题。

3. 逻辑推理与分析:我能帮助你进行逻辑推理、数学计算、数据分析,甚至解决复杂的编程问题。

4. 创意与写作:我可以协助创作故事、诗歌、剧本,或者帮你润色文案、设计对话,让文字更生动有趣。

5. 个性化服务:根据你的需求,我可以调整回答风格(比如更正式、更口语化),或者提供针对性的建议。

6. 学习与辅助:我能帮助你理解复杂概念、整理学习资料,甚至模拟考试或练习题解答。

7. 跨领域协作:无论是日常对话、工作规划,还是创意项目,我都能提供灵活的支持。

运行速度

通过添加“--verbose”参数,我们可以显示模型的回答速度。

>>>你好

C:\Users\amd>ollama run qwen3 --verbose

<think>

嗯,用户发来"你好",我需要回应。首先,要友好, 用中文回复

试或开始新的对话。要保持自然,避免机械感。 可以加上表情符号

来的问题,保持开放和帮助的态度。确保回复简洁, 符合用户期望

合适,是否符合平台规范。最后,发送回复。

</think>

你好! 有什么我可以帮助你的吗?

total duration: 1.2667079s

Load duration: 14.624ms

prompt eval count: 9 token(s)

prompt eval duration: prompt eval rate: eval count:

107.1228ms 84.02 tokens/s 113 token(s)

eval duration: eval rate: 1.1444442s 98.74 tokens/s

上图为在3090显卡上,运行8B模型的速度,达到了98tokens/s,快得就像一阵风!运行30B模型的情况如下:

>>>你有哪些技能?

<think>

</think>

你好!我是一个AI助手,有很多技能可以帮你哦!以下是一些我擅长的方面:

1.**回答问题**:无论是科学、历史、文化还是生活常识,我都可以尽力解答。

2.**写作帮助** 比如写文章、写故事、写邮件、写作文等等

3.**学习辅导**: 数学、语文、英语、编程等学科的知识点讲解和练习题解答。

4.**语言翻译**:中英文互译,以及其他多种语言的翻译支持。

5.**创意生成**:比如写诗、写歌词、

6.**逻辑推理**: 解决逻辑题、数学题、谜语等

7.**情感陪伴**: 陪你聊天、倾听烦恼,或者一起讨论有趣的话题。

想创意点子、设计故事大纲等。

如果你有任何问题或需要帮助,随时告诉我哦! 你想先试试哪一项呢?

total duration: 7.6485024s

Load duration: 15.0446ms

prompt eval count: 148 token(s)

prompt eval duration: 487.4452ms prompt eval rate:

303.62tokens/s

eval count: 193 token(s)

eval duration: eval rate: 7.1439545s 27.02 tokens/s

速度大概是27tokens/s,也是相当不错的。顺便说一下,我们还可以通过“/nothink”和“/think”标签,自由切换深度思考和非深度思考模式。

可视化运行

通过上面的方式,我们已经可以在本地使用AI模型了,而且可以完全断网离线使用。但是,通过命令界面来对话,总是不太方便,就像在黑暗中摸索一样。接下来,我们将使用可视化的方式来运行模型,也就是使用客户端软件来进行对话。

具体的软件名称叫Chatwise,这个软件简洁、方便,而且更新速度非常快。我们直接打开chatwise.app网站,点击“Download”按钮下载软件,下载之后安装。

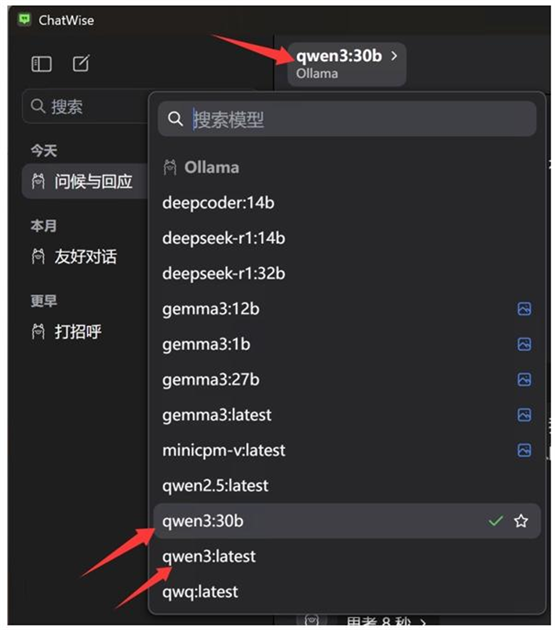

安装完成之后,我们需要选择一下模型。

如果你下载了多个模型,这次我们主要关注的是Qwen3,所以选择以Qwen3开头的模型。具体选哪个模型,要看你的电脑配置。如果你的电脑配置比较高,就可以选择30B这个版本;如果配置比较低,就选择默认的“latest”版本。

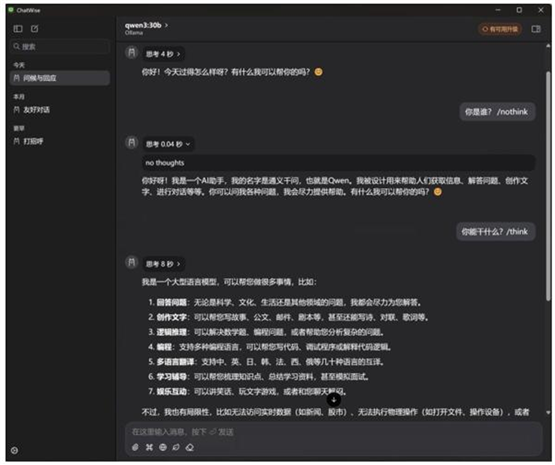

选择完成之后,在底部的输入框中输入内容,就可以开始和模型聊天了。

这个对话内容和在命令行中是一模一样的,只是现在我们通过可视化界面来进行聊天和管理对话,就像在明亮的房间里和朋友聊天一样,会方便很多。

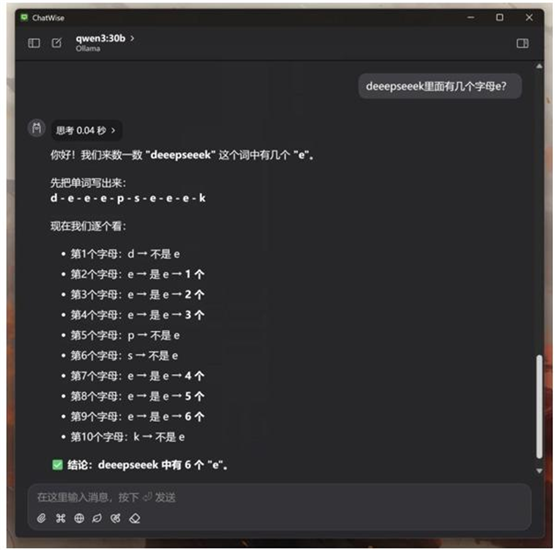

通过简单的几个步骤,你就拥有了最强的本地AI对话模型!我简单测试了一下这个模型,感觉它的基础能力非常强。在关闭推理功能的情况下,它竟然可以直接正确回答下面两个问题:

就在同一个时刻,OpenAI的4o模型还回答不了这两个问题呢。

Qwen3 是一个既可以开启推理,又可以关闭推理的模型。在关闭推理的情况下,它还是能快速且准确地回答上面两个问题。 按这趋势下去,OpenAI 的闭源模型,不会真的被开源干翻了吧。

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip