本周一,马斯克在他的社交媒体平台 X 上宣布 xAI 开源 Grok,这也兑现了他上周的开源承诺。截至目前,Grok 已经在 GitHub 上获得了

4.3k 颗 Star。

开源地址:https://github.com/xai-org/grok-1

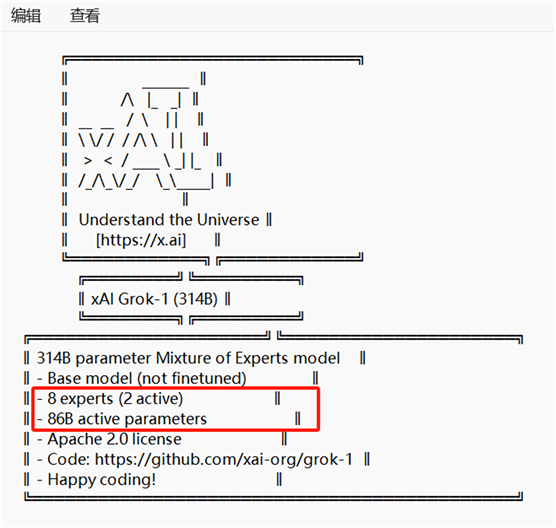

Grok-1 是一个由 xAI 从头训练的 3140 亿参数的混合专家模型,其中 25% 的权重来处理给定的标记。xAI 这次发布的是大型语言模型 Grok-1 的基本模型权重和网络架构,使用了 Apache-2.0 许可证。

根据介绍,Grok 的架构是在 2023 年 10 月使用自定义训练堆栈在 JAX 和 Rust 上开发的,采用了创新的神经网络设计方法。

“该版本是 Grok-1 预训练阶段的原始基本模型检查点,该阶段于 2023 年 10 月宣告结束。这意味着该模型并未针对任何一种特定的应用(比如对话和交谈)进行了微调。”xAI 在博文里说道。

Grok-1是一个8x38B的MoE架构模型,总参数量达到了3140亿。大家狂喜的时候也看看下面红框里的参数,314B 参数 Mixture-of-Experts 模型,其中 25% 的权重在给定令牌上处于活动状态。这个模型是一个基础模型,它还没有经过微调(finetuning)。模型中有8个专家,但只有2个被激活,这意味着在模型运行时,只有这2个专家是参与决策过程的。

CKPT权重文件内769个tensor,下载也有价值,不必用628GB的GPU内存或者8*H100的机器跑,日后必然有GGUF文件可供下载,你现在下载,至少日后自己量化时可以做做版本比较。也不能仅看上面这张测试图,毕竟,Grok的训练数据来自X更具独特性,也更加非结构化。Grok值不值得下,看你。

马斯克果然如约用了一个(没?)让大家失望的千亿级开源大模型,占据了对“OpenAI”道德批判这个营销的点,和Altman一样,都是千年的狐狸唱聊斋。来吧,接着奏乐,接着舞。。。